C’è un motivo per il quale “Something Big Is Happening” di Matt Shumer sull’AI è diventato virale

Un testo potente che mette in scena urgenza e paura sull’intelligenza artificiale, ma non per le ragioni che pensi

C’è una ragione semplice per cui il post di Matt Shumer, CEO e co-fondatore di OthersideAI/ HyperWrite, ha fatto il giro del mondo: è una rara occasione in cui qualcuno non si limita a spiegare l’intelligenza artificiale ma prova a farla sentire, e per farlo usa un artificio narrativo impeccabile che rimanda ad un'emozione molto forte con una data precisa: febbraio 2020, l’ultima normalità prima dello strappo. Da lì in poi mette in scena un’esperienza emotiva condivisibile, la sensazione che “stia succedendo qualcosa” mentre quasi tutti continuano a vivere come se nulla stesse cambiando.

La viralità nasce da questa promessa: non sei davanti all’ennesimo articolo sull’AI, sei davanti a un avvertimento. Chi lo legge ha l’impressione di ricevere un messaggio riservato: “noi l’abbiamo già visto accadere, ora tocca a voi”.

Il testo crea un corto circuito tra capacità tecnologiche, percezione sociale e decisioni economiche.

«Se hai provato ChatGPT nel 2023 o a inizio 2024 e hai pensato “si inventa le cose” o “non è così impressionante”, avevi ragione. Quelle prime versioni erano davvero limitate. Allucinavano. Dicevano con sicurezza assurdità. - afferma Shumer - Ma quello era due anni fa. Nel tempo dell’AI, è preistoria».

La cosa più importante che Shumer dice (senza dirlo esplicitamente)

Shumer descrive un passaggio dell’intelligenza artificiale da “strumento utile” a “sostituto operativo” dove lui dà istruzioni, si allontana dal computer e torna a lavoro finito, testato, iterato, “rifinito” da un modello che sembra avere persino una forma di gusto.

È un racconto che parla di workflow: come si lavora, quanto tempo serve, quanta intermediazione umana resta.

Quello che spaventa è l’idea banale e materialissima della macchina che porta a termine.

Oltre ogni romanticismo, qui c’è un fatto che spesso ci sfugge: nella storia delle tecnologie non è mai servita la perfezione, l’impatto nasce quando diventa abbastanza buono da cambiare perché conviene, accelera, riduce costi, e quindi “si può provare”. Abbiamo ormai superato la soglia del giocattolo.

Il limite del racconto

La parte più discutibile del testo è sulla capacità dei modelli che possono migliorare a scatti rispetto all’impatto reale sul lavoro e sulle professioni.

Esistono attriti enormi: responsabilità legali, compliance, reputazione, integrazione nei sistemi, qualità dei dati, governance, regole interne, assicurazioni, contenziosi. In altre parole: un modello può saper fare qualcosa molto prima che un’organizzazione decida di fidarsi a sufficienza da metterlo in produzione.

L’impatto più probabile

Se guardiamo alla realtà con un minimo di freddezza, l’effetto più verosimile nel breve non è “spariscono i lavori”, è “cambia la struttura del lavoro”.

La parola chiave è compressione: dei tempi (ciò che richiedeva giorni “deve” richiederne ore); dei team (meno persone per lo stesso output); dei ruoli junior (meno apprendistato, meno “rampe di ingresso”); delle retribuzioni (soprattutto per freelance e attività standardizzabili).

È una trasformazione che non fa rumore come un licenziamento di massa annunciato in conferenza stampa, ma che nel tempo può erodere pezzi interi di filiere: redazioni, traduzioni, produzione di contenuti, back office, customer care, analisi di base, contabilità “di routine”, document review.

Il post di Shumer, quando parla di “entry-level white collar” colpisce un nervo scoperto: se l’AI diventa il tuo collega instancabile e a basso costo, la prima cosa che salta è l’idea stessa di fare esperienza.

Perché è diventato virale proprio adesso

Il ragionamento arriva in un momento in cui la percezione pubblica è spaccata: molti hanno provato strumenti gratuiti e li ricordano come imprecisi, altri usano modelli più avanzati nel lavoro quotidiano e vedono un salto. Shumer costruisce tutta la sua tesi su questo divario: la distanza tra “ho provato e non mi ha impressionato” e “lo uso e mi sta cambiando il modo di lavorare”.

Questo divario è reale perché le decisioni aziendali e politiche si prendono spesso su percezioni. Se il pubblico sottovaluta, arriva impreparato. Se i vertici sopravvalutano, tagliano e automatizzano male, producendo danni di qualità e di fiducia.

L’Italia e il doppio rischio: ritardo e scorciatoia

In un Paese in cui la digitalizzazione procede a macchie di leopardo, la reazione più comune si divide in due. Da un lato la minimizzazione: “non ci riguarda”, “qui è diverso”, “non può funzionare nella complessità italiana”, “convincimi che sia necessario”. Dall’altro la scorciatoia: “tagliamo, sostituiamo, facciamo in fretta”, adottando strumenti e decisioni per inseguire l’efficienza senza regole e senza responsabilità chiare.

Entrambe portano allo stesso risultato: una transizione gestita male, con conflitti che generano più precarietà e disuguaglianze. Perché l’AI, quando entra come leva di produttività, redistribuisce potere, lo toglie a chi esegue senza approfondire e lo concentra in chi controlla processi e budget.

Le domande da porsi

Shumer chiude con consigli individuali: abbonati, usa il modello migliore, sperimenta un’ora al giorno, sii “early”. Sono indicazioni pragmatiche e non inutili, ma non bastano per un motivo semplice: non possiamo pensare che una trasformazione sistemica si risolva solo con una strategia personale.

La domanda vera è collettiva: chi governa questa transizione?

Chi stabilisce quando è lecito usare l’AI in una procedura? Chi risponde dell’errore? Chi firma? Chi controlla bias e qualità? Chi tutela i percorsi di ingresso? Chi paga la formazione? Chi protegge i settori dove la fiducia è parte indispensabile del servizio come la sanità, la giustizia e l’informazione?

Perché se la risposta resta “ognuno si arrangi”, l’esito è già scritto: chi ha capitale culturale e tempo si adatta, chi è più esposto paga il prezzo. E l’AI da promessa di efficienza, diventa acceleratore di fratture.

L’AI non è un meteorite, è un’infrastruttura

Il post di Shumer è virale perché mette paura in modo efficace ma il suo valore, per noi, non è la paura: è l’urgenza di spostare la discussione dal crederci o deriderla a una domanda più adulta: quali tutele e responsabilità.

L’intelligenza artificiale non è un meteorite che cade dal cielo ma un’infrastruttura che stiamo installando in tempo reale dentro lavoro, servizi, media e istituzioni. Le infrastrutture fanno sempre la stessa cosa: o le governi, o ti governano.

Gli occhi, ora, devono restare puntati sulla formazione.

Nei report ufficiali della Commissione europea sul Digital Decade l’Italia resta ferma a 45,8% di popolazione con almeno competenze digitali di base, ben sotto la media UE (55,6%) e intanto l’AI Act ha già introdotto un obbligo esplicito di AI literacy per chi sviluppa o utilizza sistemi di intelligenza artificiale (in vigore dal 2 febbraio 2025, art. 4), cioè formazione adeguata e contestualizzata per chi lavora con questi strumenti.

In parallelo, la partecipazione degli adulti all’apprendimento continua (lifelong learning) in Italia nel 2023 è indicata da fonti europee attorno all’11,6%, segnale che la riqualificazione c’è ma non è ancora la “massa critica” necessaria per reggere un cambio di paradigma.

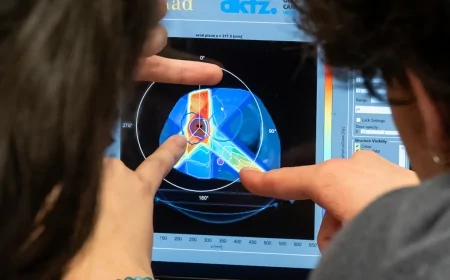

È necessario parlarne in tutte le sedi e con prospettive multidisciplinari: il medico deve parlare con l’informatico, che a sua volta ha bisogno del filosofo per mettere a fuoco implicazioni, limiti e responsabilità; e poi, perché tutto questo sia comprensibile e visibile fuori dalle stanze degli addetti ai lavori, serve un giornalismo di qualità che conosca le implicazioni dell’uso di questi strumenti e li sappia usare in modo efficace, controllando le fonti, dichiarando i metodi e sviluppando nuove tecniche di analisi. Il silenzio e la paura non terranno fuori dalla porta un cambiamento che sta già entrando nei processi, nelle decisioni e nel lavoro quotidiano.

Il futuro è già qui, scrive Shumer, forse sì. Ma la parte decisiva non è che stia già bussando alla porta: è chi gli apre.

Qual è la tua reazione?

Mi piace

0

Mi piace

0

Antipatia

0

Antipatia

0

Amore

0

Amore

0

Divertente

0

Divertente

0

Arrabbiato

0

Arrabbiato

0

Triste

0

Triste

0

Oh

0

Oh

0