ChatGPT Salute: un salto carpiato nei dati sensibili e la questione della fiducia

L’intelligenza artificiale entra nel perimetro della medicina reale, serve un nuovo patto sociale tra tecnologia, sanità e cittadini

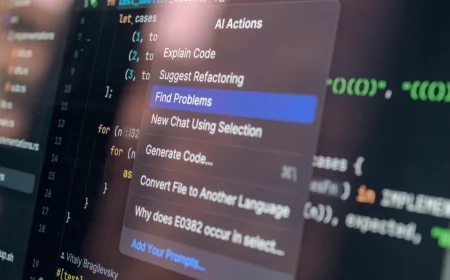

Con il lancio di ChatGPT Salute, OpenAI compie un passaggio che va ben oltre l’introduzione di una nuova funzionalità. Per la prima volta, l’uso sanitario dell’intelligenza artificiale, già ampiamente diffuso e non governato, viene circoscritto in un ambiente dedicato, separato dal resto della piattaforma e accompagnato da garanzie rafforzate su privacy e trattamento dei dati.

ChatGPT Health (ChatGPT Salute) è un’esperienza pensata per collegare referti, cartelle cliniche e app di benessere e restituire risposte più contestualizzate.

È una mossa che OpenAI definisce inevitabile, alla luce di quanto dichiarato in fase di lancio da Ashley Alexander, Vice President of Health Products in OpenAI: secondo l’azienda, oltre oltre 230 milioni di persone a livello globale ogni settimana pongono domande su salute e benessere.

Se guardiamo alle conversazioni in rete, soprattutto su LinkedIn (dove la notizia è rimbalzata con forza), emerge un quadro più interessante del lancio in sé: è in atto una discussione sul patto sociale tra tecnologia, sanità e cittadini.

La normalizzazione dell’uso medico

In particolare il dibattito pubblico oscilla tra due estremi: da una parte il timore legittimo di “ChatGPT che fa il medico”, dall’altra l’evidenza che milioni di persone già usano l’AI per orientarsi, capirci qualcosa e prepararsi a una visita. Il lancio di ChatGPT Salute nasce esattamente da qui: OpenAI prende atto di un comportamento di massa e prova a mettergli attorno guardrail tecnici e di policy.

Il messaggio ufficiale insiste su tre punti: supporto e non sostituzione del medico, compartimentazione dell’esperienza, e la promessa-chiave per la reputazione: le conversazioni di Health non verranno usate per addestrare i modelli di base.

È il tentativo di trasformare un uso “clandestino” in un uso “progettato”, e in controluce, è anche la risposta a un rischio industriale: se la gente usa comunque ChatGPT per la salute, allora tanto vale diventare lo snodo dove quei dati passano e dove si forma la fedeltà dell’utente.

Il grande terzo incomodo

Anche le posizioni ricorrenti sono essenzialmente due: la prima è l’entusiasmo pragmatico, finalmente un assistente capace di tradurre referti, mettere ordine tra app e PDF, aiutare nella continuità tra una visita e l’altra, in un sistema sanitario percepito come frammentato e con tempi stretti. È la lettura che OpenAI stessa enfatizza, anche attraverso la narrazione di chi guida il prodotto: la sanità è piena di “vuoti” tra appuntamenti e dati sparsi, e l’AI può rendere l’utente più preparato.

La seconda è lo scetticismo: “più persone useranno ChatGPT per la salute, quindi aumenterà anche il rischio”. In questa corrente c’è una parola che torna spesso: overconfidence. Se l’AI parla bene, l’utente le crede e il confine tra “spiegazione” e “consiglio clinico” diventa sottilissimo.

E poi c’è il grande terzo incomodo, che in Europa pesa più che altrove: la governance del dato sanitario. Non a caso, il servizio viene descritto come non ancora disponibile in Europa.

Qui la discussione cambia tono e il focus si sposta dall'utilità a “chi può legittimamente trattare questi dati, con quali consensi, per quali finalità, con quali controlli?”. È il punto che rende il lancio europeo un problema di architettura legale e fiduciaria.

Dal punto di vista clinico, la promessa è chiara e al tempo stesso delicata. ChatGPT Salute si propone come strumento di interpretazione, non di diagnosi: aiuta a comprendere esami di laboratorio, a prepararsi a una visita, a mettere in relazione dati provenienti da cartelle cliniche, app di benessere e dispositivi indossabili. È, in sostanza, un amplificatore cognitivo per il paziente.

Il rischio, tuttavia, è intrinseco al linguaggio stesso dell’AI: risposte coerenti, fluide e personalizzate possono essere percepite come consigli clinici, soprattutto in contesti di fragilità o ansia. Il confine tra informazione e decisione sanitaria resta sottile, e la vera sfida sarà prevenire l’interpretazione impropria da parte dell’utente.

Privacy “rinforzata”: promessa necessaria, ma non sufficiente

OpenAI parla di protezioni dedicate, isolamento, cifratura mirata e controlli più stringenti per un’area separata. È un linguaggio che serve a un obiettivo preciso: convincere che in “Health” ci sia un diverso perimetro di rischio.

Tuttavia, per quanto le misure tecniche siano importanti, la fiducia si conquista con la chiarezza su casi limite e responsabilità. Chi intercetta l’utente che sta interpretando male un sintomo grave? Come si gestisce la persona vulnerabile, l’ansioso, l’ipocondriaco che alimenta compulsivamente la ricerca di conferme? In sanità, l’errore più comune non è il bug: è il fraintendimento.

Per questo, la notizia vera non è “arriva ChatGPT Salute”, ma: chi si prende cura della relazione tra informazione e decisione?

Sul piano legale, ChatGPT Salute entra in uno dei territori più regolati in assoluto. I dati sanitari rientrano nelle categorie particolari di dati personali e richiedono consensi espliciti, specifici e granulari per ogni finalità. La scelta di OpenAI di creare un ambiente separato, con memorie dedicate e l’esclusione dell’uso dei dati per l’addestramento dei modelli, è una risposta necessaria, ma non sufficiente.

Non è un caso che il servizio non sia ancora disponibile in Europa. La compatibilità con il quadro normativo europeo, tra GDPR, AI Act e responsabilità in ambito sanitario, non è un dettaglio tecnico, ma una condizione di legittimità. Qui si gioca una partita che non riguarda solo OpenAI, ma il futuro stesso delle piattaforme AI in sanità.

Un prodotto consumer che tocca un settore regolato

OpenAI insiste sul fatto che ChatGPT Health non è pensato per la diagnosi o il trattamento.

È una frase che suona come cautela clinica, ma ha anche una lettura industriale: restare dal lato “informativo” aiuta a non scivolare nel territorio più duro delle certificazioni sanitarie.

Nella percezione del pubblico, tuttavia, un’AI che legge referti e conosce farmaci e storia clinica assume già i contorni di una consulenza sanitaria. Indipendentemente dalle cautele dichiarate dall’azienda, il punto decisivo è quello percepito dall’utente quando è solo, davanti a un valore fuori range nelle analisi.

A questo si aggiunge un ulteriore livello di complessità, già ampiamente documentato nel dibattito internazionale: l’utilizzo dell’AI come surrogato dello psicologo o del supporto emotivo. Studi, analisi accademiche e prese di posizione di organismi sanitari internazionali hanno evidenziato come molte persone ricorrano a chatbot conversazionali per affrontare ansia, stress, solitudine o sintomi depressivi, attratte dalla disponibilità continua, dall’assenza di giudizio e dal linguaggio empatico simulato. Tuttavia, come più volte ricordato anche in ambito di salute mentale, il rischio non è solo quello di indicazioni inappropriate, ma di una dipendenza relazionale da uno strumento che non possiede capacità diagnostiche, responsabilità clinica né la possibilità di intercettare segnali di crisi acuta, ideazione suicidaria o peggioramento psicopatologico. In questo contesto, l’AI può offrire un supporto percepito, ma non una presa in carico, con il pericolo concreto di ritardare l’accesso a cure professionali proprio nei momenti di maggiore vulnerabilità.

Etica e trasparenza: il problema della fiducia

C’è un tema che nelle conversazioni emerge con una franchezza che raramente si vede nei lanci tech: l’AI sanitaria prospera perché esiste un vuoto, da qui la provocazione inevitabile: è accettabile che la porta d’ingresso alla comprensione del proprio stato di salute sia un prodotto privato globale, anziché un’infrastruttura pubblica o almeno un ecosistema certificato e integrato con la medicina territoriale?

In altre parole: ChatGPT Salute è un referendum implicito su come vogliamo organizzare la sanità nell’era dei dati.

Tra promessa di empowerment, nodi regolatori e nuovi equilibri di mercato, l’ingresso strutturato dell’AI nella salute personale apre una fase che impone responsabilità etica.

Ogni strumento che opera in ambito salute vive di fiducia che, in questo caso, dipenderà dalla trasparenza dei limiti. Chi intercetta i casi a rischio? Come viene gestita l’overconfidence dell’utente? Quali segnali inducono l’AI a raccomandare un contatto umano immediato?

L’etica dell’AI sanitaria si misura in ciò che il sistema sceglie di non fare e in come comunica questa scelta all’utente. Senza una progettazione esplicita di questi confini, anche il miglior assistente rischia di trasformarsi in un oracolo percepito come infallibile.

Economia e marketing: il vero valore è la relazione

Dal punto di vista economico, ChatGPT Salute intercetta uno dei mercati più rilevanti e sensibili del digitale: quello della salute personale dove il valore risiede nella relazione continuativa con l’utente. Diventare il luogo in cui le persone “pensano” e governano la propria salute significa occupare uno spazio strategico tra paziente, sistema sanitario e industria del benessere.

È una mossa che parla anche al marketing in termini di posizionamento come infrastruttura cognitiva di riferimento. Un asset potente, purché sostenibile nel tempo sul piano reputazionale.

E’ utile, solo se cambia il modello di responsabilità

ChatGPT Salute mette in evidenza un vuoto strutturale: sistemi sanitari frammentati, tempi di visita e difficoltà di accesso alle informazioni inserendosi per colmare questo spazio.

La domanda finale è chi governerà l’integrazione? Piattaforme private globali o ecosistemi pubblici e professionali capaci di coniugare innovazione, equità e responsabilità clinica?

ChatGPT Salute può essere un acceleratore di alfabetizzazione sanitaria, e in parte lo è già. Ma per essere davvero un passo avanti, e non un moltiplicatore di ansia o disinformazione ben scritta, dovrà dimostrare almeno tre cose nel tempo: trasparenza sulle fonti e sui limiti, gestione robusta dei casi a rischio, integrazione sensata con professionisti e servizi.

Qual è la tua reazione?

Mi piace

1

Mi piace

1

Antipatia

0

Antipatia

0

Amore

1

Amore

1

Divertente

0

Divertente

0

Arrabbiato

0

Arrabbiato

0

Triste

0

Triste

0

Oh

1

Oh

1